解决robots.txt无法被识别问题

2011年8月18日最新更新方法:在httpd.ini的伪静态规则中,添加红色的代码即可解决robots.txt无法被识别问题了!RewriteRule /robots.txt /robots.txt [L]

当wordpress用了google-xml-sitemap插件后,会在选项中看见这么一句话“由 WordPress 生成的虚拟 robots.txt 文件已经启用,请确保 blog 文档中已无原来的 robots.txt 文件”大概意思就是该插件已经在网站中创建robots.txt并写入了一些规则,但是这个robots.txt文件你是根本找不到在哪里的。。。。

就算你在本地新建一个robots.txt然后放入服务器根目录,该文件还是不会被识别,可恶就可恶在这里。

那么我们如果还需要对robots.txt写入一些规则的话,应该怎么办呢?

本猫推荐安装KB Robots.txt插件来解决问题,只有4.13kb的大小,但很实用。

官方下载地址

安装完毕后,在wordpress后台会多出kb-robotstxt插件的详细设置。

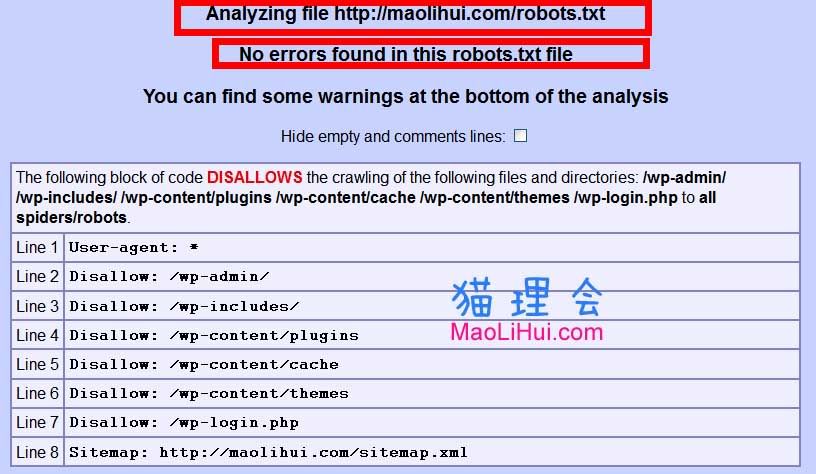

我的robots.txt写法是

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /wp-login.php

Sitemap: https://maolihui.com/sitemap.xml

一般wordpress都这样写,大家只要把最后的sitemap中的maolihui.com换成你的域名就可以了。

最后推荐一个网站,可以检验robots.txt的书写语法是否正确↓

http://tool.motoricerca.info/robots-checker.phtml

不过要注意,使用这个工具,请把robots.txt里的汉字注释清除,它识别不了汉字;如果有汉字在里面的话,它就不认为这是一个robots.txt文件了。

下面是猫理会验证的结果,没发现错误,喵哈哈。

另外,Google网站管理员工具也可以在线验证robots文件,google是支持中文注释的。

要分析网站的 robots.txt 文件,请按以下步骤操作:

使用 Google 帐户登录 Google 网站管理员工具。

在”控制台”中,点击所需网站的网址。

点击工具,然后点击分析 robots.txt

解决了我纠结了好几天的问题,给力啊。 😎